Reseña histórica

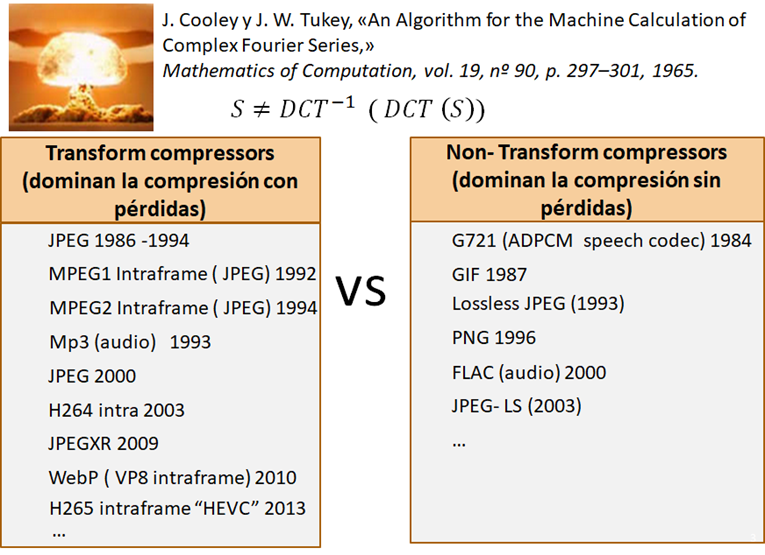

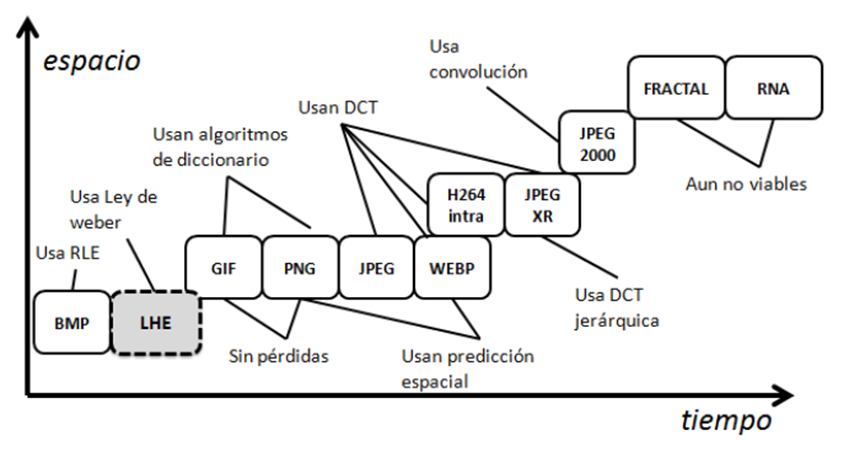

En 1965 se publicó el primer artículo sobre la transformada rápida de Fourier. Aunque inicialmente fue creada con usos militares para detectar mediante sismógrafos los posibles ensayos nucleares soviéticos, enseguida fue utilizada ampliamente para el procesamiento de señal y en concreto para la compresión con pérdidas. Con la llegada de internet en los 80 se vio claramente la necesidad de desarrollar un formato con pérdidas para almacenar y transmitir imágenes como fué JPEG.

El motivo por el que no se utiliza el paso al dominio de la frecuencia para la compresión sin pérdidas es que es muy difícil mantener bajo control el error porque es una transformación no reversible completamente. Sin embargo, la cuantización y eliminación de componentes frecuenciales de una señal ha resultado ser una técnica muy adecuada para eliminar información de una imagen o del audio sin dañar demasiado la calidad.

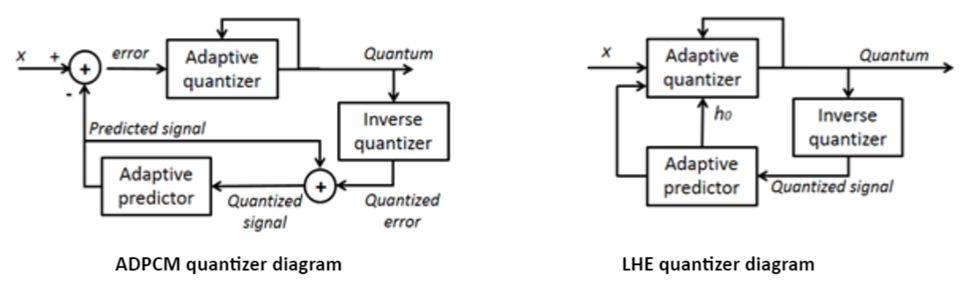

Esto ha hecho que los «transform compressors» dominen la transformación con pérdida mientras que los “non-transform compressors” dominan la transformación sin pérdidas , como GIF o PNG . De hecho los pocos intentos que se han hecho en el espacio con técnicas similares al ADPCM para transformar con pérdidas no han dado los resultados con la calidad que ofrece, por ejemplo JPEG. Y por ello nunca se contempló el dominio del espacio seriamente para la compresión con pérdidas.

Principios de LHE

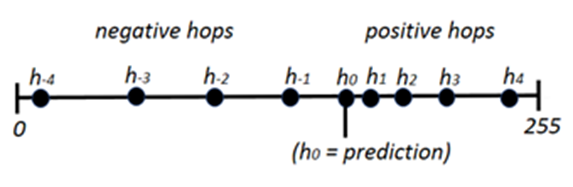

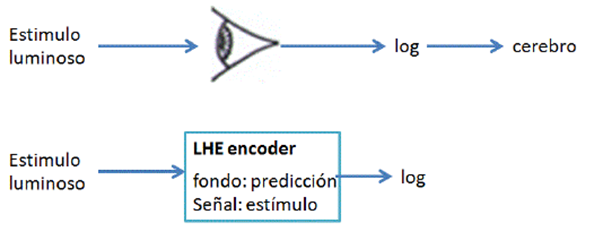

LHE es un algoritmo de compresión de señales que trabaja en el dominio del espacio y se basa en la ley de Weber-Fechner. LHE hace una predicción por cada muestra y a partir de ella configura un cuantizador (hops) de distribución asimétrica, que tiene en cuenta la fracción de Weber. Si la predicción resulta ser buena, los hops se compactan para ganar precisión si las variaciones de señal son bajas.

Esta estrategia permite elegir la mejor configuración de cuantizador para cada muestra (se pueden manejar hasta 1024 cuantizadores distintos sin necesidad de almacenarlos, solo por evolución de la distribución de hops), proporcionando 10 dB más de calidad que ADPCM para el mismo bitrate.

LHE se fundamenta en la Ley de Weber (hops) y en la fracción de Weber (h1):

- Ley de Weber: la respuesta del ojo es lineal ante los cambios logaritmicos de señal (variacion respecto de color de fondo). LHE reproduce ese esquema de funcionamiento.

LHE cuantiza la señal de entrada, no el error en la predicción. Cada hop (también llamado quantum) tiene una correspondencia directa con un valor de la señal, sin necesidad de sumar el quantum a la predicción como hace ADPCM. Este mecanismo no fue inventado en los años 80 y por ello en la carrera de la compresión con pérdidas, la basada en frecuencia (JPEG, basada en DCT) adelantó a la basada en espacio (ADPCM y similares.).

La complejidad computacional es muy similar a ADPCM, lo que le hace extraordinariamente ligero, pero proporciona 10 dB mas de calidad que ADPCM.

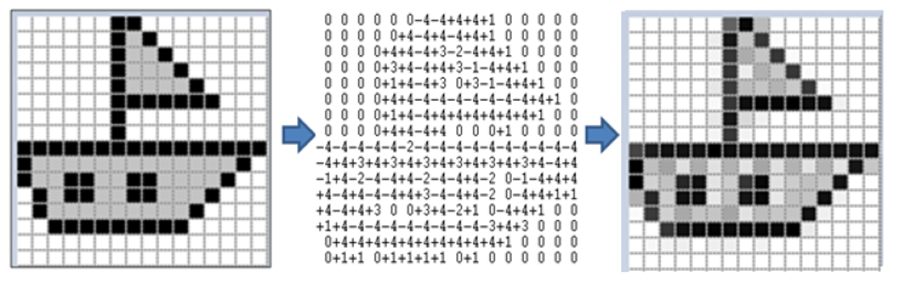

El ojo diferencia 50 tonos de gris en torno al brillo medio o “predicción” o “color de fondo”. En el caso de LHE las imágenes son transformadas en hops, que a pesar de tener solo 9 grados de libertad (en lugar de 50 como tiene el ojo), permiten codificar todo el rango de variación de la señal, cometiendo más errores donde hay mayor contraste (los cuales son menos percibidos por el ojo).

La cuantización LHE se usa en combinación con otras técnicas específicas como son la relevancia perceptual y el elastic downsampling.

- h1, Fracción de Weber: La mínima variación respecto a la predicción que podemos percibir es la fracción de Weber (un 2%, aunque aumenta en penumbra y deslumbramiento). La mínima variación en LHE es el valor del primer hop, h1. Los hops h1 y h-1 son obtenidos por simple adición a h0 (predicción). Los demás se obtienen por ecuaciones exponenciales que se tienen precalculadas para cada h0 y h1, requiriendo aproximadamente 5 KB de caché para funcionar.

Si el valor de la predicción es bueno, h1 se disminuye en 1 hasta alcanzar un valor mínimo de 4. Si el valor es malo, se aumenta a 10 instantáneamente. Esto permite mayor precisión en función de si la señal fluctúa mucho o fluctúa poco.

Ventajas de LHE

Cabe destacar dos aspectos fundamentales:

- Velocidad HD < 1ms

- Robustez ante pérdidas

La velocidad es un punto fuerte debido a su baja complejidad computacional. Para ejecutarse necesita muy poca memoria (espacio) y muy pocas operaciones (tiempo).

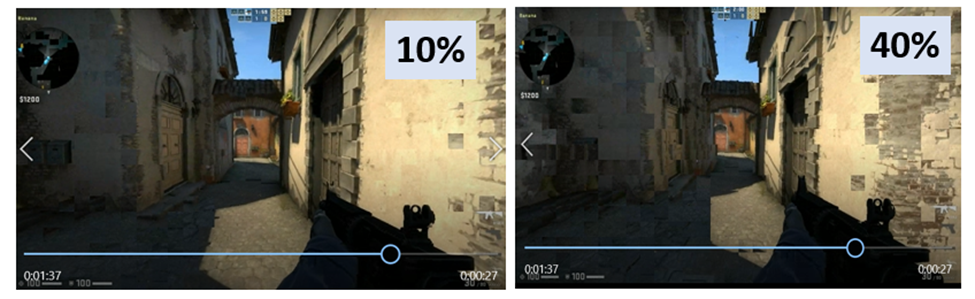

En cuanto a la robustez es inigualable. En las imágenes, se muestran codificaciones LHE con pérdidas del 10% y del 40% respectivamente, algo imposible de soportar para los codificadores actuales. Los códecs actuales (mpeg2, H264, h265, VP8, etc.) soportan con muchos errores un 1% y con un 5% ya se corrompen del todo y se congelan, lo cual es incompatible con la conducción remota.

La velocidad de codificación de LHE es otra de sus ventajas para la conducción remota. LHE codifica más rápido por software que implementaciones HW de H264, debido a su baja complejidad computacional. Esto es debido a que LHE ha sido diseñado para aplicaciones de tiempo real estrictas como cloud gaming y una de sus posibilidades es la conducción remota, la cual comparte exigencias de latencia, velocidad y robustez con el cloud gaming.

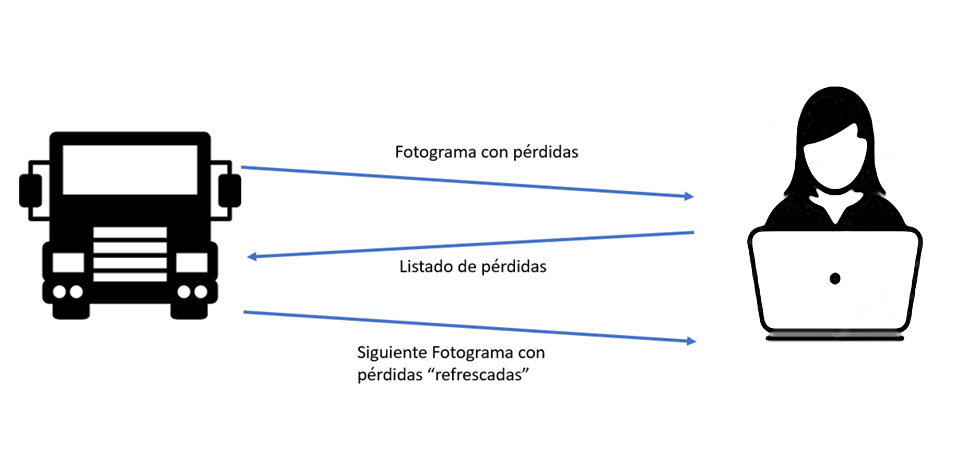

El canal de retorno desde el player es fundamental para minimizar la experiencia negativa del usuario ante la pérdida de paquetes , que se traduce en pérdidas de porciones (bloques) de la imagen hasta que dichos bloques no son refrescados con información completa (no diferencial). Mediante el canal de retorno, el tiempo que dichos bloques no son refrescados (y por tanto están congelados) en el player disminuye al mínimo posible (el tiempo que consume un único fotograma).